تکنولوژی چگونه میتواند با افراطیگرایی و مزاحمت آنلاین مقابله کند

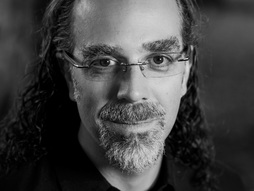

وقتی در سال ۲۰۰۶کارکردن در گوگل را شروع کردم، فیسبوک تنها دو سال داشت، و توییتر هنوز متولد نشده بود. و من در سایۀ هیبت مطلق اینترنتو تمام وعدههایش بودم که ما را به هم نزدیکتر میکند و باهوشترمان میکند و آزادترمان میکند. اما همانطور که ما کار الهامبخش ساختن موتورهای جستوجو، و سایتهای انتشار ویدیوو شبکههای اجتماعی را انجام میدادیم، جنایتکاران، دیکتاتورهاو تروریستها فهمیدند که چگونه از آن پلتفرمهای مشابه علیه ما استفاده کنند. و ما پیشبینی نکردهبودیمکه چطور متوقفشان کنیم. در طول چند سال گذشته، قدرتهای ژئوپولیتیکبرای خرابکاری به عرصۀ آنلاین آمدند. و در پاسخ، گوگل از من و تعدادی همکار برای تأسیسگروه جدیدی به نام Jigsaw پشتیبانی کرد، با یک تعهد که مردم را در برابر تهدیدهاییمثل افراط گرایی خشن، سانسور، آزار و شکنجه در امان داریم -- تهدیداتی که برای من احساسی بسیار شخصی استچونکه من در ایران به دنیا آمدم،

و پس از یک انقلاب خشن از آنجا خارج شدم. امّا من متوجّه شدم حتی اگر ما همۀ منابع کل کمپانیهای تکنولوژیدر دنیا را در اختیار داشته باشیم هنوز شکست خورده قلمداد میشویم اگر یک عنصر حیاتی را نادیده بگیریم: تجربیات انسانی قربانیانو عاملان آن تهدیدات.

چیزهای چالشبرانگیز زیادی هستند که امروزمیتوانم دربارهشان با شما صحبت کنم. من بر روی تنها دو مورد تمرکز میکنم. اولینش تروریسم است. پس ما برای درک فرایند افراطیگری، با دهها نفر از اعضای سابقگروههای خشن تندرو دیدار کردیم. یکی از آنها یک دختر مدرسهای انگلیسی بود، که او را از یک پروازدر فرودگاه هیترو لندن پایین آورده بودند چرا که میخواست خودش رابرای پیوستن به داعش به سوریه برساند. و او ۱۳ ساله بود. پس من با او و پدرش نشستم و پرسیدم، «چرا؟» و او گفت: «من عکسهایی میدیدماز اینکه زندگی در سوریه چه شکلی است، فکر میکردم که میرومو در دیزنیورلد اسلامی زندگی میکنم.» این چیزی بود که او در داعش دید. او فکر میکرد که با یک برد پیت جهادی ملاقات و ازدواج میکند و هر روز به مرکز خرید میرودو بعد از آن به خوشی زندگی میکند.

داعش فهمیده که چهچیزمردم را تحریک میکند، و آنها با دقت برای هر مخاطبپیامی میسازند. فقط ببینید چه تعداد زبان هست که آنها اطلاعات موردنظرشان رابه آن زبانها ترجمه میکنند. آنها جزوات و برنامههای رادیویی و ویدیویی میسازند نه فقط به زبان انگلیسی و عربی، بلکه آلمانی، روسی، فرانسه، ترکی، کُردی، عبری، چینی ماندارین. من حتی یک ویدیوی تولیدشدۀ داعش را دیدمکه به زبان اشاره بود. فقط برای یک لحظه به آن فکر کنید: داعش زمان گذاشته و کوشیده تا مطمئن بشود که پیامشحتی به ناشنوا و کمشنوا هم میرسد. در واقع آنچه داعش رادلربا و هوشربا میکند شایستگی تکنولوژیک آن نیست. بلکه بینش داعش به تعصبات،آسیبپذیریها و خواستههاییست که مردم میکوشند بدان برسند

و داعش به آنها این اجازه را میدهد. این نشان میدهد چرا برای یک پلتفرم آنلاین کافی نیست که تمرکزش رامعطوف به حذف اطلاعات جمعشده کند. اگر میخواهیم که در عرصۀ تکنولوژیتلاش معناداری بکنیم آن تلاش باید در راه مبارزه با افراطیگری باشد، ما بایستی با سفر انسان به درون خود بیاغازیم.

پس ما به عراق رفتیم برای اینکه با مردان جوانی حرف بزنیم که با وعدۀ قهرمانی وعدالت به داعش پیوسته بودند، کسانی که برای داعش مبارزه کردند اما بالاخره آنگاهکه وحشیانگی قانون داعش را دیدند فرار کردند. خب من در زندان موقتی درشمال عراق نشستهام با این فرد ۲۳ ساله که به عنوانبمبگذار انتحاری آموزش دیده بود پیش از آنکه فرار کند. او گفت: «سرشار از امید به سوریه رسیدم، و ناگهان، دو چیز ارزشمندم مصادره شد: گذرنامه و موبایلم.» نمادهایی از آزادی فیزیکی و دیجیتالش را در بدو ورود از او گرفتند. و این چیزی است که اواز لحظۀ ناامیدیاش به من گفت. گفت: «میدونی در تام و جری اونجایی که جری میخواد فرار کنهو تام در رو قفل میکنه و کلید رو قورت میده

و دیدی که کلید از برآمدگی گلوشرد میشه و پایین میره؟» و درسته، من واقعاً میتوانستمآنچه را که او میگفت تصور کنم، واقعاً میتوانستم با احساسی کهمیکوشید منتقل کند ارتباط برقرار کنم، که یک عذاب بود، وقتی میدانی که هیچ راه خروجی نیست.

میخواستم بدانم: چه میشد اگر وقتی میخواست خانه را ترک کند چیزی نظر او را عوض میکرد؟ پس پرسیدم: «اگر تو آنچه را که امروز دربارۀ رنج و فساد و وحشیگری میدانی -- همان روز اول که رفتی میدانستی، بازهم میرفتی؟» و او گفت، «آره.» و فکر کردم، «خدایا، گفت آره.» بعد گفت: «آن موقع من شستوشوی مغزی شدهبودم، اطلاعاتی را که در تضادبا عقایدم بود نمیپذیرفتم. نمیتوانستم قانع شوم.»

«خب اگر شش ماه پیش از آنکه خانه را ترک کنی آنچه را که امروز میدانی میدانستی چه؟»

«به گمانم آن موقع ممکن بودکه نظرم تغییر کند.»

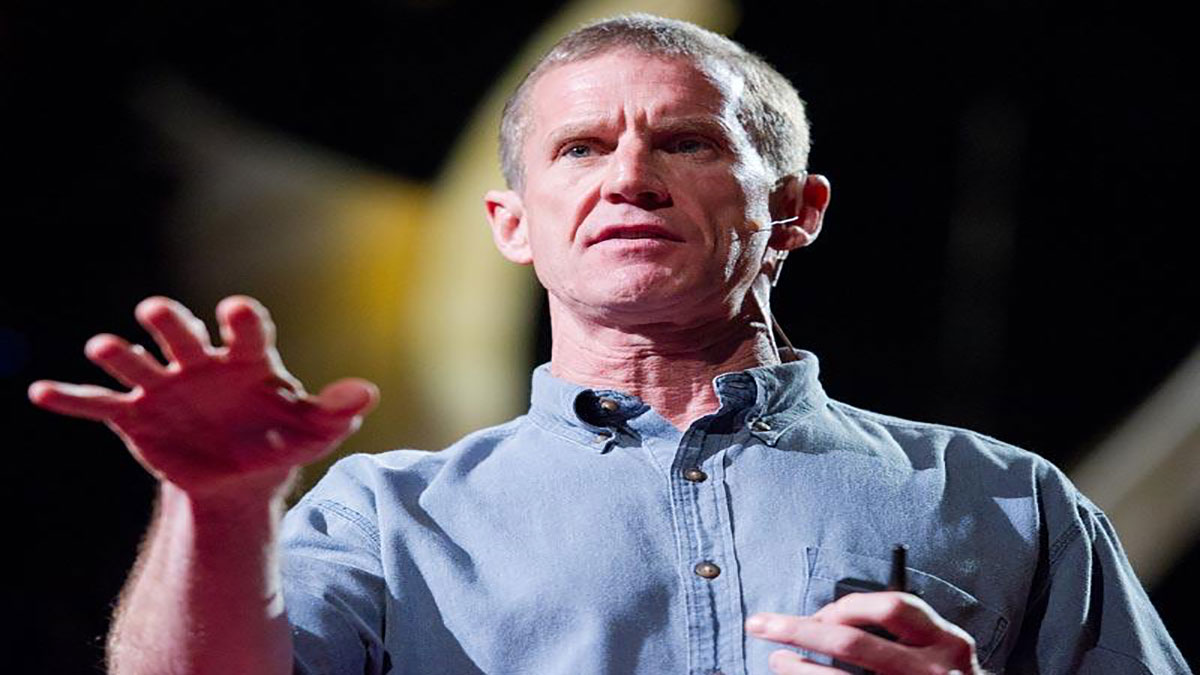

افراطیگری گزینش بلی یا خیر نیست. بلکه یک فرایند است،دورانی که مردم پرسشهایی دربارۀ ایدئولوژی، دین و اوضاع زندگی دارند. و آنها برای رسیدنبه پاسخها آنلاین میشوند، جاییکه فرصتی برای رسیدن به آنهاست. و ویدیوهای آنلاینی از کسانیکهپاسخ را میدانند وجود دارد -- برای نمونه فراریان از داعش که داستان ورود و خروجشان از خشونت را میگویند؛ مشابه داستان آن مردیکه من در زندان عراقی دیدم. محلیهایی هستند که باتلفن همراه فیلم آپلود کردهاند از اینکه زندگی تحت قانون خلافت داعش واقعاً چگونه است. روحانیانی هستند که تفسیرهای صلحآمیزیاز اسلام را ارائه میدهند. اما میدانید؟ این افراد معمولاً توان عرضه و تبلیغاتی را که داعش دارد، ندارند. آنها جانشان را با حرفزدن و مقابلهکردن علیه تبلیغات تروریستی به خطر میاندازند. اما به شکل غمانگیزی حرفشان به گوش مردمی که نیاز به شنیدن آن حرفها دارند نمیرسد. و میخواستیم ببینیماگر تکنولوژی بتواند آن را تغییر دهد.

پس در سال ۲۰۱۶ مابا Moonshot CVE همکاری کردیم تا رهیافتی نو را برای مقابله با افراطیگری آزمایش کنیم بنام «روش راهنمایی مجدد.» که از قدرت تبلیغات آنلاین بهره میبرد تا آن صداهای معتبری را که به روکردن دست داعش مشغولند به آنهایی که دربرابر پیام داعشآسیبپذیرند برساند. و اینطور کار میکند: کسی به دنبال محتوایافراطگرایانه میگردد -- مثلاً کسی «چگونه عضو داعش شوم؟» راجستوجو میکنند -- یک آگهی ظاهر میشود که دعوتشان میکند تا ویدیویی را از یک روحانی یا کسی که از داعش فرار کرده یا کسی که پاسخی قانعکنندهداشته باشد، ببینند. و این دعوت، بر مبنایمشخصات هویتیشان نیست، بلکه هدف تعیین چیزی کاملاً مرتبط با تردید یا پرسششان است.

طی آزمایش هشتهفتهایماندر زبانهای انگلیسی و عربی، به بیش از ۳۰۰٫۰۰۰ نفرکه از خود تمایل یا همدلی به گروههای جهادی نشان دادند رسیدیم. این افراد حالا ویدیوهایی میبینند که میتواند مانع از این شود که تصمیمی خانمانبرانداز بگیرند. و بهخاطر اینکه افراطیگری خشنمحدود به یک زبان، دین یا ایدئولوژی نیست، روش راهنمایی مجددهماکنون بسمت جهانیشدن میرود تا محافظ مردم باشد که در اینترنت توسطایدئولوژیهای خشن، وسوسه نشوند، خواه آن ایدئولوژیها اسلامگرایان باشندخواه برتریپنداران سفیدپوست یا دیگر افراطگرایان خشن. با این هدف که به آنهاشانس شنیدن صحبت فردی را که در آن سوی این سفر است بدهیم؛ به آنها شانس انتخاب مسیری متفاوت را بدهیم.

معلوم میشود که اغلب، آدمبدها در بهرهبردن از اینترنت موفقاند، نه بخاطر اینکه نابغههای تکنولوژیاند، بلکه بخاطراینکه میدانند چه چیز افراد را تحریک میکند. میخواهم مثال دوم را به شما بگویم: مزاحمت آنلاین. مزاحمان آنلاین نیزمیخواهند بفهمند که چهچیز دیگری را تحریک میکند. امّا نه برای نابودکردنشان،مثل آنچه داعش میکند، بلکه برای رنجدادن آنها. تصور کن: یک زن هستی، متأهلی، و یک فرزند داری. مطلبی در رسانههای اجتماعی مینویسی، در یک از نظر، نوشته میشودکه به شما تجاوز خواهد شد. چیزی که پسرت خواهد دید، جزئیات اینکه کِی و کجا. در واقع، آدرس خانهاتبرای هرکسی قابل مشاهده است. مثل تهدیدی واقعی به نظر میآید. به نظرت باید به خانه بروی؟ گمان میکنی که باید به کاریکه مشغول بودی ادامه بدهی؟ ادامهدادن به کارموجب خشم فرد مزاحم میشود؟

آزارگری آنلاینهنر فاسدِ پیبردن به این است که چه چیز اوقات مردم را تلخ میکند، چه چیز میترساندشان، چهچیز سبب احساس ناامنی در آنها میشود، و پس از پیبردن،افزدون فشار تا آنگاه که ساکتاند. وقتی مزاحمت آنلاین مهار نشود، آزادی بیان خفه میشود. و حتی اگر افراد گفتوگو را میزبانی کنند سر آخر تسلیم میشوند، قسمت نظراتشان را میبندندو انجمنهایشان را تعطیل میکنند. که در واقع به این معناستکه ما فضاهای آنلاین را برای ملاقات و تغییر نظرات از دست میدهیم. و فضاهای آنلاینی که میماند، ما با افراد همفکرمان بهاتاقهای پژواک سرازیر میشویم. امّا این گسترش اطلاعات غلط را موجب میشود؛ که قطبیشدن فضا را تسهیل میکند. چه میشود اگر در عوض تکنولوژی بتواندهمدلی را به اندازۀ کافی ایجاد کند؟

این پرسشی بود که موجب همکاری ما با تیم سوءاستفادهستیزِ گوگل، ویکیپدیا و روزنامههایی همچون نیویورکتایمز شد. میخواستیم ببینیم که اگر بتوانیم مدلهایی از یادگیری ماشین بسازیم که بتواند اثرگذاری احساسی زبان را بفهمد. آیا میتوانیم پیشبینی کنیم کهچه نظراتی محتملترست که موجب شوند افراد گفتوگوی آنلاین را ترک کنند؟ و این کار سادهای نیست. برای هوش مصنوعی دستاورد بیاهمیتی نیست که بتواند چیزی مثل این را انجام دهد. منظورم این است که تنهااین دو نمونه پیام را که میتوانست هفتۀ پیش برای منارسال شود در نظر بگیرید. «شکستن یک پا در TED!» و... «من پاهای تو را در TED میشکنم.»

(خنده)

شما انسانید، و همین خاطر تفاوت برای شما واضح است، حتی اگر کلمات کاملاً شبیه باشند. اما برای هوش مصنوعی، برای آموزش مدلها به تمرین نیاز است تا این تفاوت را تشخیص دهد. زیبایی ساختن هوشی مصنوعیکه بتواند تفاوت را بگوید این است که میتواند میزانمضربودن پدیده را اندازه گیرد، و آن هدف ما در ساخت تکنولوژیمانبه نام چشمانداز بود. به یاری چشمانداز، برای مثال نیویورکتایمز، فضاهای آنلاینش برایگفتوگو افزایش یافتهاست. پیش از همکاریمان، آنها تنها در پای ۱۰ درصد ازمقالاتشان نظرات را فعال کرده بودند. به یاری یادگیری ماشین، آن عدد هماکنون بیش از ۳۰ درصد است. پس سه برابرش کردهاند، و ما هنوز تازه شروع کردهایم.

امّا این دربارۀ راهی فراتر ازفقط کارآمدکردن مدیریت است. اکنون میتوانم شما را ببینم، و میتوانم اثری را که سخنانمبر شما میگذارد بفهمم. شما این فرصت آنلاین را ندارید. تصور کنید اگر یادگیری ماشینبتواند به نظردهندگان، آنگاه که تایپ میکنند، دربارۀ اثرگذاری واژگانشانبازخورد آنی بدهد، مشابه آنچه حالات چهره در یک بحث رو در رو میکند. یادگیری ماشین بینقص نیست، و هنوز اشتباهات زیادی دارد. امّا اگر ما بتوانیم تکنولوژیی بسازیم که بتواند اثرگذاری عاطفی زبان را درک کند، میتوانیم همدلی را بسازیم. بدین معنا که میتوانیم میانافراد گفتوگو داشتهباشیم افرادی با گرایشهای سیاسی متفاوت، جهانبینی متفاوت، ارزشهای متفاوت. و ما میتوانیم این فضاهای آنلاین راکه بسیاری از ما ترکش کردهایم دوباره بازسازی و تقویت کنیم.

هنگامی که مردم از تکنولوژی برای بهره برداری و آسیب رساندنبه دیگران استفاده می کنند، آنها به شکار ترسهاو آسیبپذیریهای ما مشغولند. اگر تاکنون فکر کردیممیتوانیم اینترنتی بسازیم که از سویۀ تاریک انسانیت در امان باشد، در اشتباه بودیم. اگر امروز بخواهیم تکنولوژیی راه بیندازیم که بتواند بر چالشهای پیشرویمان غلبه کند، بایستی تمام توانمان را برای درک مسائل و یافتن راهحلهایی که به هماناندازۀ مشکلات انسانیاند بکارگیریم. بیایید عملیاش کنیم.

سپاسگزارم.

(تشویق)