عصر ایمان کورکورانه به دادههای عظیم باید به پایان برسد

متن سخنرانی :

الگوریتمها همه جا هستند. آنها برندهها و بازندهها راردهبندی کرده و از هم جدا میکنند برندهها استخدام میشوند یا یک پیشنهاد خوب مالی میگیرند. اما بازندهها حتی مصاحبه هم نمیشوند یا هزینه بیشتری برای بیمه میپردازند. ما با فرمولهای مرموزی سنجیده میشویمکه درکشان نمیکنیم. که معمولاً سیستمی برای تجدید نظر ندارند. این سوالی را بر میانگیزد: اگر الگوریتمها اشتباه کنند چطور؟برای ایجاد یک الگوریتم دو چیز نیاز دارید: داده، چیزی که در گذشته اتفاق افتاده، و تعریفی برای موفقیت، چیزی که به دنبال آن هستیدو معمولاً انتظارش را دارید. شما به الگوریتم با دیدنو درک کردن آموزش میدهید. الگوریتم درک میکند که چه چیزهاییبا موفقیت ارتباط دارند. چه موقعیتی به موفقیت منتهی میشود؟

در واقع، همهاز الگوریتمها استفاده میکنند. فقط آنها را به صورت کد نمینویسند بگذارید مثالی بزنم. من هر روز از یک الگوریتمبرای پخت غذای خانوادهام استفاده میکنم. دادههایی که استفاده میکنم شامل مواد موجود در آشپزخانهام، زمانی که دارم، و هدفی که دارم میشود. و من این دادهها را مدیریت میکنم. من آن بستههای کوچکنودل رامن را غذا به حساب نمیآورم.

(خنده حضار)

تعریف من از موفقیت این است: یک غذا موفق استاگر فرزندانم سبزیجات بخورند. این خیلی متفاوت میشداگر پسر بزرگترم مسئول بود. از نظر او موفقیت این استکه بتواند زیاد نوتلا بخورد. ولی منم که موفقیت را انتخاب میکنم. من مسئولم.نظر من است که اهمیت دارد. این اولین قانون الگوریتمهاست.

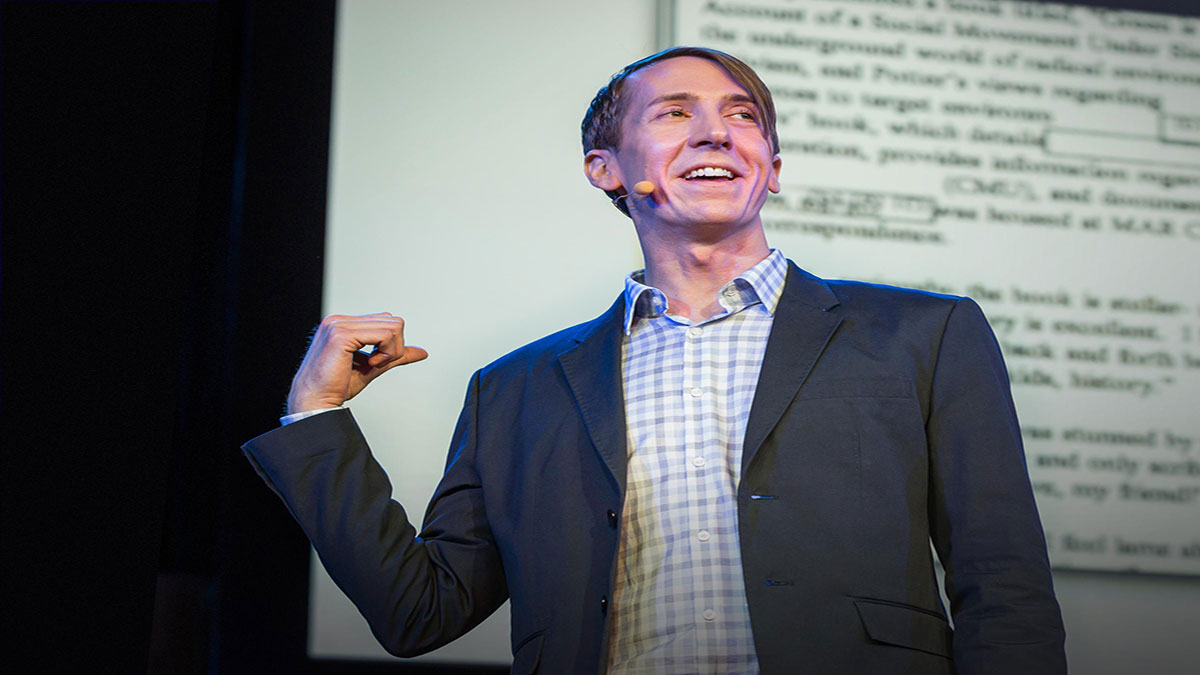

الگوریتمها سلایقی هستندکه در قالب کد ارائه میشوند. این با چیزی که بیشتر مردم در موردالگوریتمها فکر میکنند تفاوت دارد. آنها فکر میکنند که الگوریتمهاعینی، درست و علمی هستند. این یک حقهٔ بازاریابی است. این هم یک حقهٔ بازاریابی است که شما را با الگوریتمها بترسانند، که شما را وادار به اعتماد به الگوریتمهاو ترس از آنها کنند به دلیل ترس و اعتماد شما به ریاضیات. باور کورکورانه به کلاندادههامیتواند عواقب نادرستی داشته باشد. این کیری سورس است.او مدیر یک دبیرستان در بروکلین است. در سال ۲۰۱۱، او به من گفتمعلمهای مدرسهاش با یک الگوریتم مرموزو پیچیده امتیازبندی میشوند که نام آن«مدل ارزش افزوده» است. من به او گفتم، «خب، فرمول را پیدا کنو به من نشان بده من آن را برایت توضیح میدهم». او گفت: «من سعی کردمکه فرمول را بدست بیاورم، اما رابط ادارهی آموزشبه من گفت که ریاضیات است و من آن را درک نخواهم کرد.»

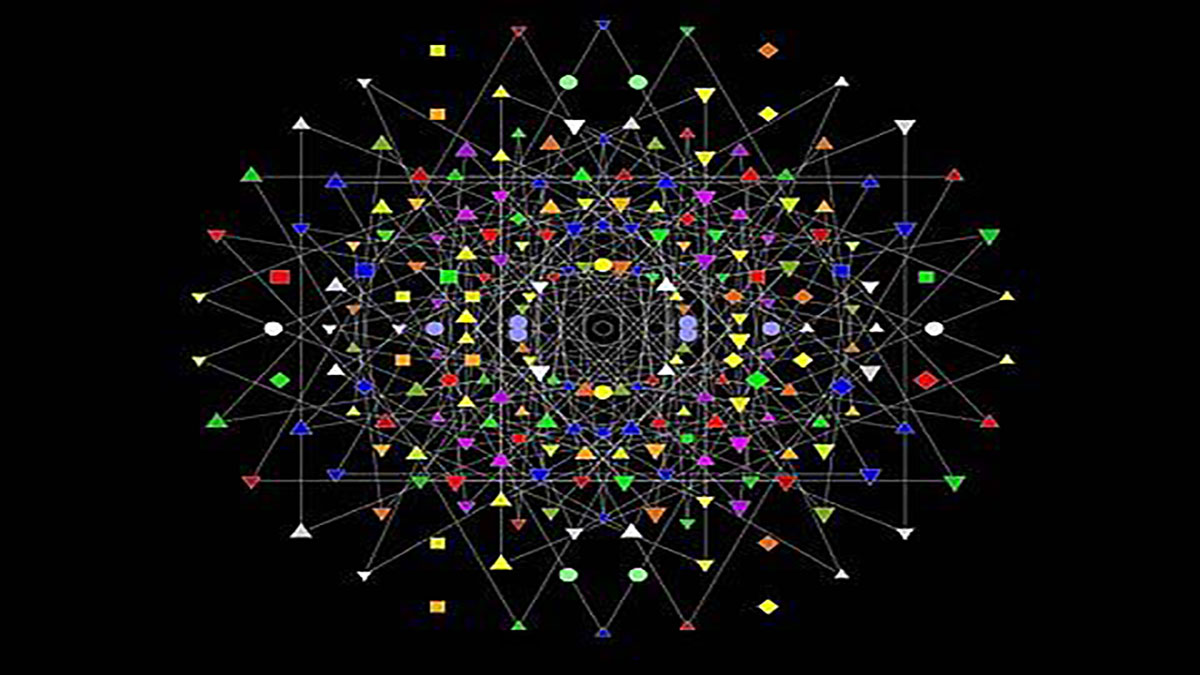

بدتر هم میشود. روزنامه «نیویورک پست» درخواستیمربوط به «سند آزادی اطلاعات» منتشر کرد، نام تمام معلمهاو تمام نمراتشان را به دست آورد و برای خجالتزده کردن معلمانآنها را منتشر کرد. وقتی من خواستم فرمولها و کد را از همین طریق ببینم، به من گفتند نمیتوانم. از این کار منع شدم. بعداً فهمیدم که هیچکس در شهر نیویورکبه آن فرمول دسترسی نداشت. هیچکس آن را نمیفهمید. بعداً یک فرد واقعاً باهوشبه نام «گری روبنشتاین» درگیر این موضوع شد. او ۶۶۵ معلم که در دادههاینیویورک پست بودند را یافت که هر یک، دو نمره داشتند. اگر یک معلم در دو کلاس هفتم و هشتم تدریس کند ممکن است این اتفاق رخ دهد. او تصمیم گرفت این دادهها را ترسیم کند. هر نقطه نشاندهندهی یک معلم است.

(خندهی حضار)

این چیست؟

(خندهی حضار)

هرگز نباید برای ارزیابی افرادمورد استفاده قرار میگرفت. تقریباً یک تولیدکنندهی اعداد تصادفی است.

(تشوق حضار)

اما استفاده شد. این سارا ویساکی است. او به همراه ۲۰۵ معلم دیگر از ناحیهی مدارس واشنگتون دیسی اخراج شد. علیرغم اینکه توصیهنامههای خیلی خوبی از طرف مدیر و خانوادههای شاگردانش داشت.

میدانم بسیاری از شماچه فکر میکنید، خصوصاً دانشمندان داده،و خبرگان هوش مصنوعی. شما فکر میکنید، «من هرگز الگوریتمیبه این ناسازگاری نخواهم ساخت». اما الگوریتمها میتوانند اشتباه کنند، حتی آثار مخرب عمیقی داشته باشند،در صورتی که نیتشان خیر بوده است. برخلاف هواپیماییکه بد طراحی شده است و سقوط میکند و همه آن را میبینند، الگوریتمی که بد طراحی شده باشد ممکن است مدت زیادیبه صورت خاموش تخریب کند.

این راجر ایلز است.

(خندهی حضار)

او در سال ۱۹۹۶ فاکس نیوز را تأسیس کرد. بیش از ۲۰ زن از آزار جنسیشکایت کردند. آنها میگفتند که اجازه موفقیتدر فاکس نیوز را ندارند. او سال گذشته برکنار شد،اما اخیراً دیده شده که مشکلات باقی ماندهاند. این مسئله این سؤال را برمیانگیزد: فاکس نیوز باید چه کندتا بهبود یابد؟

خب، چطور است فرایند استخدم را با یک الگوریتم یادگیری ماشین جایگزین کنیم؟ به نظر خوب میآید، نه؟ به آن فکر کنید. داده، دادهها چه خواهند بود؟ یک انتخاب منطقی سابقه درخواستهای استخدامدر ۲۱ سال گذشتهی فاکس نیوز است. منطقی است. تعریف موفقیت چطور؟ یک انتخاب منطقی این است که، چه کسی در فاکس نیوز موفق است؟ به نظرم کسی که مثلاً،چهار سال در آنجا مانده باشد و حداقل یک بار ارتقاء گرفته باشد. به نظرم منطقی است. سپس الگوریتم را آموزش میدهیم. الگوریتم آموزش داده میشود که بگرددو بفهمد چه چیزی منجر به موفقیت شده است. بر اساس این تعریف که چه جور درخواستهایی در گذشتهمنجر به موفقیت شدهاند؟ حالا به این فکر کنید که اگر الگوریتم را روی درخواستهای فعلی اجرا کنیمچه خواهد شد؟ زنها حذف میشوند چون شبیه افرادی که در گذشته موفق بودهاند به نظر نمیرسند.

الگوریتمها چیزی را عادلانه نمیکنند اگر آنها را خوشبینانهو کورکورانه به کار ببرید. چیزی را عادلانه نمیکنند. آنها تجربیات و الگوهای گذشتهی ما را تکرار میکنند. وضعیت موجود را خودکارسازی میکنند. اگر دنیای ما بینقص بود،این عالی بود، اما اینطور نیست. و اضافه میکنم که اکثر شرکتهادادخواستهای شرمآوری ندارند، اما به دانشمندان داده در این شرکتها گفته میشود که دادهها را دنبال کنند، و روی دقت تمرکز کنند. به این فکر کنید که این به چه معنی است. چون ما همه تعصباتی داریم،یعنی ممکن است تبعیض جنسی یا هر نوع تعصب دیگر را به کد تبدیل کنیم.

یک آزمایش فکری، چون آن را دوست دارم: یک جامعه کاملاً تفکیکشده -- تفکیکشدهی نژادی، در تمام شهرها،تمام محلهها و پلیسها را برای تشخیص جرم فقط به محلهی اقلیتها میفرستیم. دادههای دستگیریها خیلی تبعیضآمیز خواهد بود. چه خوا هد شد اگر علاوه بر این، تعدادی دانشمند داده بیابیم و به آنها پول بدهیم تا محل وقوعجرایم بعدی را پیشبینی کنند؟ محلهی اقلیتها. و یا پیشبینی کنند مجرمِ بعدیکه خواهد بود؟ یک [فردِ] اقلیت. دانشمندان داده به عظمتو دقتِ مدلِشان افتخار خواهند کرد، و حق دارند.

آیا این جدی نیست؟اما ما این تفکیکهای شدید را در بسیاری شهرهای بزرگ و کوچک داریم، و شواهدی زیادی از تعصبات پلیسی و دادههای سیستم قضایی،در دست داریم. و در واقع نقاط کانونی را پیشبینی میکنیم، مکانهایی که جرم در آن رخ خواهد داد. در حقیقت، جنایتکاری فردیرا پیشبینی میکنیم. میزان جنایتکاری افراد را. سازمان خبری پروپابلیکابه یکی از الگوریتمهای به ظاهر [تشخیصدهندهی] «ریسک تکرار جرم» نگاهی انداخته است. که در فلوریدا حین صدور رأیقضات استفاده میشود. برنابرد، در سمت چپ، مرد سیاهپوست،امتیاز ۱۰ از ۱۰ گرفته بود. دیلان، در سمت راست، ۳ از ۱۰. ۱۰ از ۱۰، ریسک زیاد.۳ از ۱۰، ریسک کم. هر دوی آنها به خاطر حمل مواد مخدر دستگیر شده بودند. هر دوی آنها سابقهدار بودند، اما دیلان سابقهی تبهکاری داشت ولی برنارد نداشت. این مسئله به این خاطر اهمیت داردکه هر چه امتیاز شما بالاتر باشد، احتمال اینکه محکومیت طولانیتریبگیرید افزایش مییابد.

قضیه چیست؟ دادهشویی. فرایندی که طی آن فناوریگرایانحقایق زشت را در جعبههای سیاه پنهان میکنند. و آن را «عینی» میخوانند؛ آنرا «شایستهسالاری» خطاب میکنند. در حالی که این الگوریتمها مخفی،مهم و ویرانگر هستند، من برای آنها نامی در نظر گرفتهام: «سلاح کشتار ریاضی.»

(خنده حضار)

(تشویق حضار)

اینها همه جا هستند،و این یک اشتباه نیست. این شرکتهای خصوصیالگوریتمهایی خصوصی برای اهداف شخصی میسازند. حتی همانهایی که دربارهشان صحبت کردمبرای معلمان و پلیس عمومی، آنها هم توسط شرکتهای خصوصیساخته شده بودند و به مؤسسات دولتی فروخته شده بودند. به آن «سس مخصوص» خودشان میگویند برای همین نمیتوانند دربارهی آنبه ما توضیح دهند. قدرت خصوصی هم هست. آنها به خاطر داشتن حق محرمانگی سود میبرند. ممکن است فکر کنید،چون این چیزها خصوصی هستند و رقابت وجود دارد، شاید بازار آزاداین مسئله را حل کند. اینطور نخواهد شد. پول زیادی از بیعدالتیبه دست میآید.

علاوه بر این، ما عاملهای اقتصادیِ منطقیای نیستیم. همهی ما تعصباتی داریم. ما همه نژادپرست و متعصبیمبه طرقی که دوست داشتیم نباشیم، به طرقی که حتی نمیدانیم. هر چند در مجموع این را میدانیم چون جامعهشناسانمدام این را با آزمایشهایی که میکنند، ثابت کردهاند. آنها تعدادی درخواستاستخدام را ارسال میکنند که به یک اندازه واجد شرایطنداما برخی نامهای سفیدپوستی و برخی نامهای سیاهپوستی دارند، و نتیجه همواره ناامیدکننده است، همیشه.

بنابراین این ما هستیم که تعصب داریم، و این تعصبات رابا دادههایی که جمعآوری میکنیم به الگوریتمها تزریق میکنیم. مثلاً من تصمیمی گرفتم به ریمن نودل فکر نکنم به نظرم نامربوط بود. اما با اعتماد به دادههاییکه از تجربیات گذشته یاد میگیرند و با انتخاب تعریف موفقیت، چطور میتوانیم از الگوریتمهاانتظار داشته باشیم جان سالم به در ببرند؟ نمیتوانیم. باید آنها را بررسی کنیم. باید عدالت را در آنها بررسی کنیم.

خبر خوب اینکه،میتوانیم عدالت را در آنان بررسی کنیم. میتوان الگوریتمها را بازجویی کرد. و آنها هر بار به ماحقیقت را خواهند گفت. و میتوانیم آنها را درست کنیم.میتوانیم آنها را بهتر کنیم. من به این حسابرسی الگوریتمی میگویم، و آن را به شما توضیح میدهم.

نخست، بررسی درستی دادهها. برای الگوریتم ریسک تکرار جنایتکه دربارهاش صحبت کردم، بررسی درستی داده به این معنی استکه باید با این حقیقت کنار بیاییم که در ایالات متحده، سیاهپوستانو سفیدپوستان به میزان یکسانی گُل میکشند اما سیاهپوستان به مراتببیشتر دستگیر میشوند چهار تا پنچ برابر بیشتروابسته به منطقه. این تعصب در سایر ردههای جرم چطور است، و چطور آن را در نظر بگیریم؟

دوم، باید دربارهی تعریف موفقیت فکر کنیم، آن را حسابرسی کنیم. الگوریتم استخدام را به خاطر دارید؟دربارهی آن صحبت کردیم. فردی که چهارسال بماندو یک بار ارتقاء گرفته باشد؟ خب، این یک کارمند موفق است. اما علاوه بر این کارمندی است که در فرهنگش مورد حمایت قرار گرفته است. بنابراین، آن هم میتواند متعصبانه باشد. باید این دو را از هم جدا کنیم. برای مثال باید به مصاحبهی ارکستر ناپیدا بنگریم. در این مصاحبه افراد مصاحبهگردر پسِ یک پرده هستند. آنچه میخواهم به آن فکر کنم این است که افرادی که گوش میدهندمتوجه شدهاند چه چیزی مهم است و چه چیزی مهم نیست، و به خاطر آنحواسشان پرت نمیشود. زمانی که مصاحبهی ارکستر ناپیدا شروع شد، تعداد زنان در ارکسترهاپنچ برابر شد.

سپس، باید دقت را در نظر بگیریم. اینجاست که مدل ارزش افزودهبرای معلمان بلافاصله در هم میشکند. البته هیچ الگوریتمی بینقص نیست، بنابراین باید خطایتمام الگوریتمها را در نظر بگیریم. این خطاها تا چه حد پر تکرارند،و این مدل برای چه کسانی بد عمل میکند؟ هزینهی این خطا چقدر است؟

و در نهایت، باید آثار بلند مدت الگوریتمها را در نظر بگیریم. حلقههای بازخوردی که تشدید کنندهاند. به نظر انتزاعی میرسد، اما تصور کنید اگر مهندسان فیسبوکپیش از آنکه تصمیم بگیرند فقط چیزهایی را به ما نشان بدهند که دوستانمان فرستادهاند، این مسئله را در نظر نگرفته بودند.

دو پیام دیگر هم دارم،یکی برای دانشمندان داده. دانشمندان داده: ما نبایدداوران حقیقت باشیم. ما باید مترجمان گفتگوهای اخلاقی باشیم که در جامعهی بزرگتر رخ میدهد.

(تشویق حضار)

و بقیهی شما، کسانی که دانشمند داده نیستند: این یک امتحان ریاضی نیست. این یک جنگ سیاسی است. ما باید مسئولیتپذیری رااز اربابانِ الگوریتمیمان مطالبه کنیم.

(تشویق حضار)

عصر ایمان کورکورانهبه دادههای عظیم باید پایان بیابد.

خیلی متشکرم.

(تشویق حضار)