چطور به کامپیوترها فهمیدن عکسها را میاموزیم

متن سخنرانی :

اجازه دهید چیزی را به شما نشان دهم.(ویدیو)دختر: بسیار خوب،آن گربه روی یک تخت خواب نشسته است. این پسر در حال نوازش فیل است. آنها مردمی هستند در حال سوار شدن به هواپیما. این یک هواپیمای بزرگ است.

فی-فی-لی: این یک کودک سه ساله است که آنچه که در مجموعه ایاز عکسها میبیند را توصیف میکند. ممکن است او هنوز چیزهای زیادیبرای یادگیری درباره این جهان داشته باشد. اما او در یک کار خیلیمهم دیگه تخصص دارد: درک کردن آنچه که میبیند. جامعه ما از لحاظ فناوریاز هر زمان دیگر پیشرفتهتر است. ما آدمها را به ماه میفرستیم،تلفنهایی ساختیم که با ما صحبت میکنند یا ایستگاههای رادیویی سفارشی طراحی کردیمکه می توانند فقط موسیقی را که دوست داریم پخش کنند. با این حالپیشرفته ترین ماشینها و رایانههای ما هنوز هم در این کار (درک تصاویر)مشکل دارند. بنابراین امروز من اینجا هستم که یک گزارش پیشرفت به شما بدهم در مورد آخرین پیشرفتدر تحقیق ما بر روی بینایی رایانهای، یکی از پیشرفتهترین وبصورت بالقوه انقلابیترین فن آوریها در علوم رایانهای.

بله، ما نمونه اولیه ماشینهایی را داریمکه خودشان میتوانند رانندگی کنند، اما بدون دید هوشمند (smart vision)نمی توانند فرق بگذارند بین پاکت کاغذی مچاله در جادهکه میشه از روش با ماشین رد شد. و یک سنگ همان اندازه که نباید از روش رد شد ما دوربینهای (با وضوح) مگاپیکسلعالی ساخته ایم، اما به نابیناها بینایی ندادهایم. هواپیماهای بدون سرنشینکه برفراز زمینهای وسیع پرواز کنند، ولی فناوری بینایی کافی برای کمک به ما در رهگیری تغییرات جنگلهای بارانینداریم. دوربین های امنیتی همه جا هست، ولی وقتی یک کودک در استخر در حال غرق شدن است به ما هشدار نمیدهند. تصاویر و ویدیوها در حال تبدیل شدن بهجز مهمی از زندگی جهانی هستند. تصاویر با سرعتی فراتر از آنچه هر انسانیا گروهی از انسانها، بتواند امیدوار به دیدن آنها باشدتولید میشوند، و من و شما در این TED یعنی تولید تصاویر مشارکت میکنیم. با این وجود پیشرفتهتریننرم افزارها همچنان در فهم و مدیریت این حجم عظیم مشکل دارند. به عبارت دیگر در مجموعبه عنوان جامعه ما کاملا کور هستیم، چون باهوشترین ماشینهای ما هنوز نابینا هستند.

شاید بپرسید "چرا انقدر سخته؟" دوربینها میتوانند تصاویریمثل این را بگیرند: با تبدیل نور به آرایه دو بعدی اعداد به نام "پیکسل" ولی اینها فقط اعداد بی روح هستند، هیچ معنی به خودی خود ندارند. مثل اینکه:شنیدن با گوش کردن یکی نیستند، عکس گرفتن با دیدن یکی نیستند، یا اینکه منظور از دیدن واقعا فهمیدن نیست. در حقیقت ۵۴۰ میلیون سال وقت مادر طبیعت صرف انجام این کار سخت شده و بیشتر این تلاش به تکامل ابزار پردازش دید مغزمان اختصاص داده شده و نه به خود چشمها. پس، دیدن با چشم آغاز میشود، ولی در حقیقت در مغز شکل میگیرد.

برای ۱۵ سال با شروع از دکترا در کلتک و سپس رهبری آزمایشگاه بینایی در استانفورد، من با مربی هایم، همکارانم و شاگردانمتلاش کرده ام که به رایانه ها یاد بدهیم که ببینند. اسم زمینه تحقیقاتی مابینایی رایانه ای و آموزش ماشین هست. این بخشی از زمینه عمومی تر هوش مصنوعی هست در نهایت میخواهیم به ماشین هایاد بدهیم که ببینند همانند ما: اسم گذاشتن بر روی اشیا، تشخیص افراد، استنباط سه بعدی از اشیا فهم ارتباط، احساسات، اعمال و نیت ها. من و شما وقتی نگاهمون به آدمها، مکانهاو اشیا میافتد دربارشون قصه میسازیم.

اولین قدم در راه این هدف این هستکه به رایانهها یاد بدهیم تا اشیا را ببینند؛ سنگ بنای دنیای بصری. به ساده ترین حالت این فرایند آموزشرا مانند نشان دادن تعدادی عکس آموزشی از یک شی خاص مثلا گربه ها به رایانه تصور کنید. و طراحی یک مدل (برای رایانه)که ازدیدن این عکسها یاد میگیرد. اینکار چقدر میتونه سخت باشه؟ بالاخره یک گربه مجموعه ایستاز شکل ها و رنگها، و این کاری هست که در روزهای ابتداییطراحی اشیا انجام میدادیم. ما به الگوریتم رایانه به زبان ریاضی میگوییم که یک گربه صورت گرد دارد،بدن تپل دارد، دو تا گوش تیز دارد و یک دم دراز و این کافی بود. ولی این یکی گربه چطور؟ (خنده حضار) این یکی کاملا خم شده حالا شما باید یک شکل و زاویه دید دیگه به مدل شی اضافه کنید ولی اگه گربهها قایم شده باشند چی؟ این گربه های بامزه چطور؟ جالا متوجه منظور من میشوید. حتی یک چیز ساده مثل حیوان خانگی میتونه مدلهای بینهایت گونه گون از مدل شی را ارائه کند، و این تازه فقط یک شی هست.

تقریبا هشت سال پیش یک مشاهده ساده و عمیقطرز فکر من را تغییر داد. کسی به یک کودک نمیگه چطور ببیند، به ویژه در سالهای ابتدایی. اونها این کار را از طریق تجربیات و مثالهایدنیای واقعی یاد میگیرند. اگر چشمهای یک کودک را مثل یک جفت دوربین بیولوژیک در نظر بگیرید، آنها هر ۲۰۰ میلی ثانیهیک تصویر میگیرند، مدت زمان متوسطی که حرکت چشم صورت میگیرد. پس تا سه سالگی یک کودکصدها میلیون تصویر از دنیای واقعی دیده این تعداد زیادی از مثالهای آموزشی هست. پس بجای تمرکزصرف بر الگوریتمهای بهتر و بهتر نگرش من این بود که به الگوریتمها ـآن دسته از دادههای آموزشی که به یک کودک از طریق تجربه داده میشود را در همان حجم و کیفیت بدهیم.

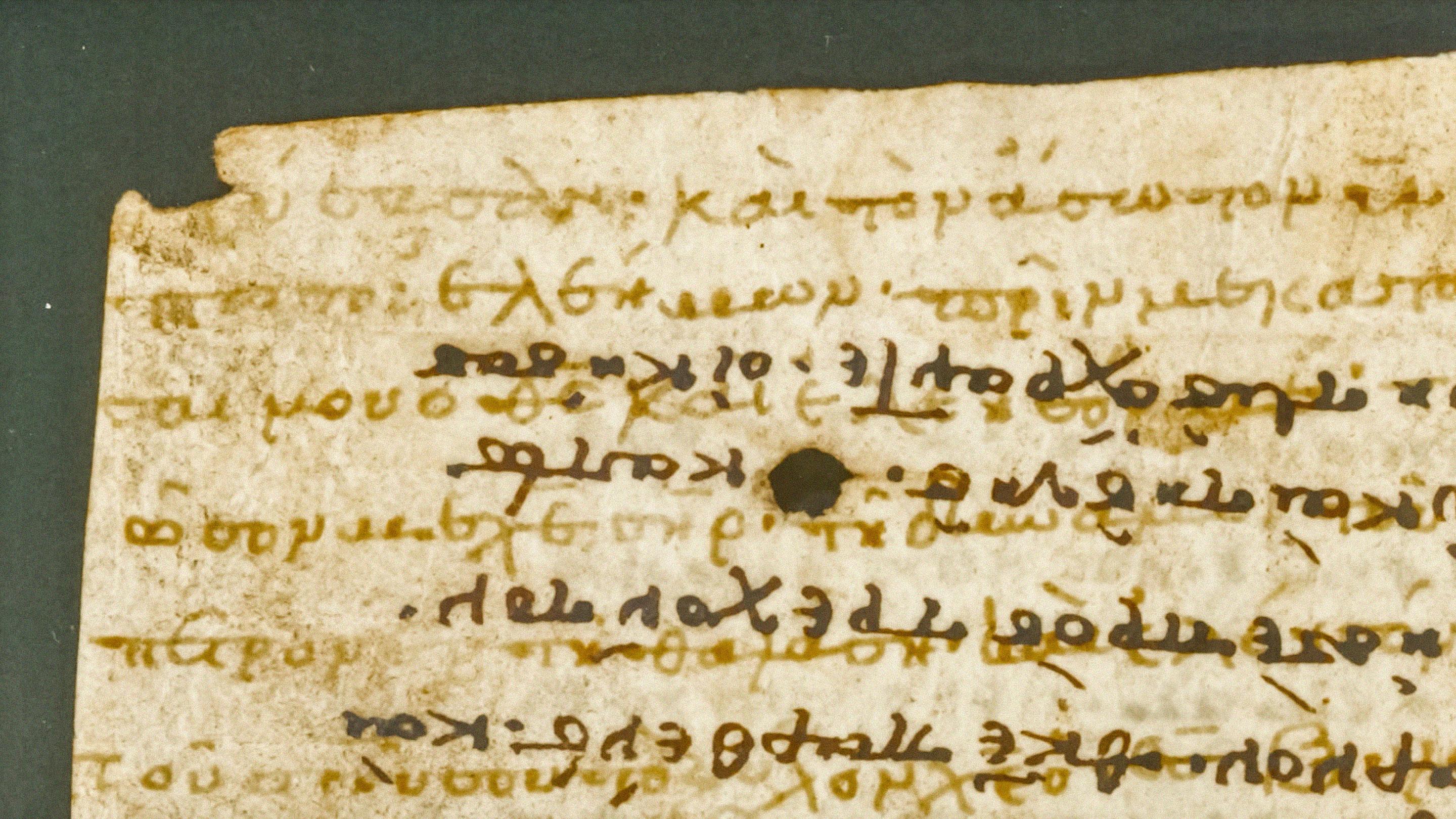

وقتی این را فهمیدیممتوجه شدیم که به جمع آوری مجموعه اطلاعات نیاز داریم که خیلی بیشتر از آنچه تاکنون داشته ایمعکس داشته باشد، احتمالا هزاران بار بیشتر، و با همکاری پرفسور کای لیدر دانشگاه پرینستون ما پروژه ImageNet رادر سال ۲۰۰۷ راه اندازی کردیم. خوشبختانه احتیاج نداشتیمکه یک دوربین روی سرمان نصب کنیم و سالها منتظر بمانیم. رفتیم سراغ اینترنت بزرگترین گنجینه عکسهاکه انسانها تاکنون آفریده اند. نزدیک به یک میلیارد عکس دانلود کردیم و از فناوری CrowdSourcingهمانند Amazon Mechanical Turk platform استفاده کردیم تا برای برچسب زدن اینعکسها به ما کمک کند. در اوج خودش، ImageNet از بزرگترین کارفرماهای Amazon Mechanical Turk بود در مجموع تقریبا ۵۰٫۰۰۰ کارمند از ۱۶۷ کشور جهان به ما کمک کردند تانزدیک به یک میلیارد عکس منتخب را اصلاح، منظم و برچسب گذاری کنند. این میزانی بود که زحمت برد برای ثبت کسری از تصویرگری که ذهن یک کودک در سالهای اولیهتکامل خود انجام میدهد.

پس از گذشت زمان و کسب تجربهایده استفاده از حجم عظیم دادهها برای آموزش الگوریتم رایانهها،شاید الان بدیهی بنظر برسد، ولی قبلا در سال ۲۰۰۷ انقدر واضح نبود. ما توی این سفر برای مدتی کاملا تنها بودیم. بعضی از همکاران نزدیکم به من توصیه کردندکه برای استخدام قطعی من کار مفیدتری بکنم و مدام برای بودجه تحقیقاتی مشکل داشتیم. یکبار با دانشجوهای تحصیلات تکمیلیامشوخی کردم که برای تامین بودجه ImageNetحشکشوییام را دوباره باز کنم. بهر حال این راهی بود که من پول تحصیلام را در آورده بودم.

پس ادامه دادیم. در سال ۲۰۰۹ پروژه ImageNet یک پایگاه داده از ۱۵ میلیون عکس در وسعت ۲۲٫۰۰۰ کلاس از شی ها که با کلمات انگلیسی روزمره منظم شده بودندتحویل داد. از لحاظ کیفیت و کمیت این مقیاس بیسابقه بود. بعنوان مثال در مورد گربهها بیش از ۶۲٫۰۰۰ (تصویر) گربه در انواع شکل ها و فرم بدن و در تمام گونههای اهلی و وحشی داشتیم. ما از اینکه ImageNet را ساخته بودیمهیجان زده بودیم و و میخواستیم که تمام دنیای تحقیقاتاز آن بهره ببرند پس به شیوه TED تمام مجموعه داده را برای دنیای تحقیقات بصورت رایگانباز کردیم. (تشویق حضار)

حالا که دادهها را برای تغذیه مغزرایانه هایمان داریم، آماده ایم که برگردیم سراغخود الگوریتم ها. اینطور شد کهوفور اطلاعات تهیه شده توسط ImageNet خیلی خوب به کلاس خاصی از الگوریتمهاییادگیری ماشینی به نام "شبکه های عصبی در هم تنیده"تطابق داشت، که پیشگامانش کونیهیکو فوکوشیما وجف هینتون و یان لیکان در دهههای ۱۹۷۰ و ۱۹۸۰ بودند. درست مثل مغز که از میلیاردهانورون پیوسته تشکیل شده یک واحد عملیاتی بنیادی در یک شبکه عصبی یک گره نورون-مانند است. از گرههای دیگر ورودی میگیرد و و خروجی را به دیگر گرهها میفرستند. به علاوه، این صدها یا هزاران یا حتیمیلیونها گره در لایههایی با سلسله مراتب منظم شدهاند، مانند مغز. در یک شبکه عصبی نوعی، برای آموزشمدل تشخیص اشیا، ۲۴ میلیون گره، ۱۴۰ میلیون پارامتر، و ۱۵ میلیارد اتصال وجود دارد. این یک مدل عظیم است. با استفاده از نیروی عظیم داده هااز ImageNet و CPU و GPU های مدرنبرای آموزش چنین مدل یکدستی، "شبکه عصبی در هم تنیده"... به شکلی که کسی انتظار نداشت شکوفا شد. تبدیل شد به معماری برتر برای تولید نتایج تازه و هیجان انگیزدر تشخیص اشیا. این یک کامپیوتر هست که به ما میگه این تصویر شامل یک گربه است و اینکه گربه کجاست. البته چیزهای بیشتری از گربه وجود دارد، پس این یک الگوریتم رایانهایهست که به ما میگوید تصویر شامل یک پسر هستو یک عروسک خرس؛ یک سگ، یک آدم، و بادبادک کوچکدر پس زمینه؛ یا تصویر چیزهای شلوغتر مثل یک مرد، تخته اسکیت، نردهها، تیر چراغ برق و چیزهای دیگر. بعضی وقتها که رایانه مطمئن نیستاز چیزی که به آن نگاه میکند، بهش یاد دادیم که به اندازه کافی باهوش باشد تا به جای کار زیادی یک جواب مطمئنبه ما بدهد، درست مثل کاری که ما انجام میدهیم، ولی در موارد دیگر الگوریتم رایانه ای مادر گفتن اینکه اشیا چه هستند فوق العاده است مثل نوع ، مدل و سال ساخت ماشین.

ما این الگوریتم را به میلیونها عکس "منظره خیابان گوگل"در صدها شهر آمریکا اعمال کردیم و چیز جالبی را متوجه شدیم: اول اینکه عقل سلیم ما را تایید کرد که قیمت خودرو وابستگی زیادی به درآمد خانوارها دارد. اما تعجب اینکه، قیمت خودروبستگی زیادی هم به نرخ جرایم در شهرها، یا الگوی رای دادن در شهرها بر اساسکدپستی دارد.

صبر کن ببینم! همین؟! آیا دیگر توانایی رایانه با توانایی انسان مطابقت دارد یا از آن پیشی گرفته؟ نه به این زودی. تا حالا به رایانه یاد دادیمکه اشیا را ببیند. این مثل این هست که کودک یاد بگیرد چند اسم بگوید. این یک موفقیت باورنکردنی است، اما فقط اولین قدم است. بزودی یک مرحله مهم طی خواهد شد و کودکان یاد میگیرند تا بصورت گفتن جمله ارتباط برقرار کنند. پس به جای اینکه بگوید این یک گربه در این عکس است که قبلا شنیدید دختر کوچولو به ما گفت این یک گربه خوابیده روی تخت است.

برای یاد دادن به رایانه که تصویری را ببیند و جملاتی تولید کند، پیوند بین دادههای عظیم و الگوریتم آموزش ماشین باید گام دیگری بردارد. حالا رایانه باید هم از تصاویر یاد بگیرد هم از جملات زبان طبیعی که توسط انسان تولید میشوند. درست مثل مغز که بینایی وزبان را به هم میآمیزد ما هم مدلی ایجاد کردیم که قسمت هایاجسام بصری مانند خرده تصاویر را به کلمات و عبارات در جملات پیوند میزند.

حدود چهار ماه پیش، بالاخره همه اینها را به هم پیوند زدیم و یکی از اولین مدلهای دید رایانهای را که وقتی یک تصویر را برای اولین بار میبیند قادر به تولید جملات همانند انسانها هست تولید کردیم. حالا آماده هستم که بهتون نشان دهم که یک رایانه وقتی تصویری که وقتی تصویری را میبیند که اون دختر کوچولوی اول سخنرانی آن را دید.

(صدای رایانه): یک مرد کنار یک فیلایستاده است. یک هواپیمای بزرگ روی باند پروازفرودگاه نشسته.

(سخنران): البته ما هنوز داریم سخت تلاشمیکنیم که الگوریتممان را بهتر کنیم، و هنوز چیزهای زیادی هست که باید یاد بگیرد. (تشویق حضار)

و رایانه هنوز اشتباه میکند.

(صدای رایانه): یک گربه زیر لحافدراز کشیده روی تخت.

(سخنران): قطعا وقتی تعداد زیادی گربه میبیند ممکن است فکر کند که همه چیز شبیه گربه است.

(صدای رایانه): یک پسربچه یک چوب بیسبال در دست دارد. (خنده حضار)

(سخنران): و اگر مسواک ندیده باشدآن را با چوب بیسبال اشتباه میگیرد.

(صدای رایانه): مردی که در خیابانکنار یک ساختمان اسب سواری میکند. (خنده حضار)

(سخنران): ما به رایانهها کلاس هنر پایه تدریس نکردیم.

(صدای رایانه): یک گورخر ایستادهدر زمینی پوشیده از علف.

(سخنران): و یاد نگرفته که قدر زیبایی مسحور کننده طبیعت را مثل من و شما بداند.

بله، سفر درازی بوده تا از سن صفر به سه سالگی برسیمدشوار بود. سختی واقعی رفتن از سه سالگی به۱۳ سالگی و فراتر هست. اجازه بدهید به شما با این تصویر پسر و کیک یادآوری کنم. تا الان به رایانه یاد دادیم که اجسام را ببیند یا حتی وقتی یک تصویر را میبیند یک داستان ساده به ما بگوید.

(صدای رایانه): یک شخص نشسته سر یک میزبا یک کیک.

(سخنران): اما در این عکس خیلی چیزهای دیگر غیر از یک آدم و کیک هست. چیزی که رایانه نمیبیند این است کهاین یک کیک مخصوص ایتالیایی که فقط در زمان عید پاک پخته میشودهست. پسر تیشرت مورد علاقهاش را پوشیده که توسط پدرش بعنوان هدیه بعد از سفربه سیدنی به او داده شده. و من و شما همه میتوانیم بگویمکه چقدر خوشحال هست و دقیقا در آن لحظه در ذهنش چه میگذرد.

این پسر من "لیو" هست. در جستجوی من برای هوش بصری مدام به "لیو" فکر میکنم و آیندهای که او زندگی خواهد کرد. زمانی که ماشینها میتوانند ببینند، پزشکان و پرستاران یک جفت چشمخستگی ناپذیراضافه خواهند داشت که به آنها کمک خواهد کرد برای تشخیصو مراقبت از بیماران. خودروها هوشمندانهتر و ایمنتردر جادهها حرکت خواهند کرد. رباتها، نه فقط انسانها به ما در خطرکردن در مناطق فاجعهزده برای نجات مصدومان و زخمیها کمک خواهند کرد. گونههای جدید خواهیم یافت،مواد بهتر، و مرزهای نادیده را با کمک ماشینهااکتشاف خواهیم کرد.

کم کم داریم به ماشینها بینایی میبخشیم. ابتدا ما به آنها دیدن را میآموزیم. سپس آنها به ما کمک میکنند تا بهتر ببینیم. برای اولین بار چشمان انسانتنها چشمانی نخواهند بود که تفکر میکنند و جهان ما را کاوش میکنند. ما نه تنها از ماشینها برایهوش آنها استفاده میکنیم، بلکه با آنها به روش هایی که نمیتوانیم تصور کنیم همکاری خواهیم کرد.

این جستجوی من است: تا به رایانه ها هوش بصری بدهم و آینده بهتری برای "لیو" و جهان خلق کنم.

متشکرم.

(تشویق حضار)