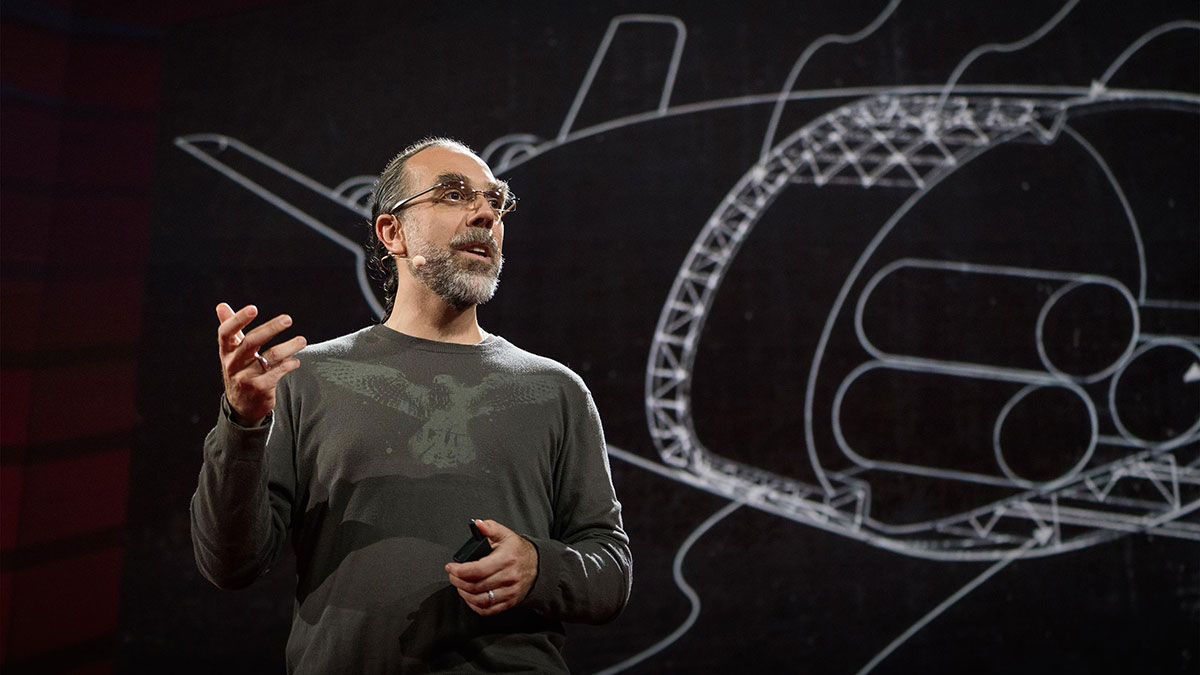

چگونه هوش مصنوعی ما را تبدیل به مردمانی بهتر میکند

متن سخنرانی :

این لی سادل هست. لی سادل یکی از بزرگترینبازیکن های Go (یک بازی فکری)در جهان هست. و در حال تجربه لحظهای هستکه دوستان من در سیلیکون ولی بهش میگن لحظه "یا پیغمبر!"(خنده حاضرین)

لحظهای که مفهمیم هوش مصنوعی واقعا داره سریعتر از چیزی کهانتظارشو داشتیم پیشرفت میکنه. پس، انسانها روی تخته Go باختهاند.در دنیای واقعی چطور؟

باید بگم که دنیای واقعی خیلی بزرگتر و بسیار بسیار پیچیدهتراز تخته بازی Go هست. (دنیای واقعی) خیلی نامرئیتر هست، ولی همچنان مساله تصمیم گیری هست. و اگر درباره برخی از تکنولوژیها فکر کنیم که در حال ظهور هستند... [Noriko [Arai اشاره کرده است کهتوانایی خواندن هنوز در ماشینها وجود ندارد، حداقل همراه با فهمیدن نیست. ولی این اتفاق خواهد افتاد. و وقتی که به وقوع بپیوندد، پس از آن، خیلی زود ماشینها تمام آنچه را کهبشر نوشته است، خواهند خواند. و این ماشینها را قادر میسازد که فراتر از انسانها به آینده نگاه کنند، همانطور که قبلاً در Go دیدهایم، اگر ماشینها به اطلاعات بیشتریدسترسی داشته باشند، میتوانند تصمیمات بهتریدر جهان واقعی نسبت به ما بگیرند. آیا این یک اتفاق خوب است؟ خب، امیدوارم که باشه.

تمام تمدن ما،هر چیزی که برایش ارزش قائل هستیم، بر پایه هوشمندی ما است. و اگر ما هوش بیشتری در اختیار داشتیم، آن وقت هیچ حد و مرزی برای کارهاییکه انسان میتواند بکند وجود نداشت. و من فکر میکنم که،همانطور که برخی توصیف کرداند، این میتواندبزرگترین رویداد تاریخ بشریت باشد. پس چرا بعضیها حرفهایی میزنند، مثلا اینکه هوش مصنوعی میتواندخاتمه دهنده نسل بشر باشد؟ آیا این یک پدیده جدید است؟ آیا فقط ایلان ماسک و بیل گیتسو استیون هاوکینگ هستند؟

راستش، نه.این ایده خیلی وقته که وجود دارد. یه نقل قول میگه: «حتی اگر میتونستیم ماشینها روفرمانبردار نگه داریم مثلا با خاموش کردنشان در لحظات استراتژیک» -- و من بعداًبه ایده «خاموش کردن»برمیگردم-- «ما به عنوان یک گونه،باید خیلی احساس پستی کنیم» کی این رو گفته؟آلن تورینگ در سال ۱۹۵۱ آلن تورینگ، همانطور که میدانیدپدر علم کامپیوتر هست. و از خیلی از جهات،پدر علم هوش مصنوعی هم هست. پس اگر درباره این مساله فکر کنیم، مساله ساختن چیزی هوشمندتر ازگونه خودمان، شاید این رو «مساله گوریل» بنامیم. چون اجداد گوریلها این کار روچند میلیون سال قبل انجام داده اند، و الان میتوانیم از گوریلها بپرسیم که: آیا این کار ایده خوبی بود؟

اینم از گوریلهایی که در جلسهای،درباره اینکه آیا ایده خوبی بود بحث میکنند و بعد از مدت کوتاهی،به این نتیجه میرسن که، نه یک ایده افتضاح بود گونه ما، در تنگنای بدی قرار دارد در واقع، شما میتوانید غم عالم رودر چشمانشان ببینید

(خنده حاضرین)

پس شاید این احساس ناراحتی از به وجود آوردنچیزی هوشمندتر از گونه خود ایده خوبی نباشد ما چه کاری از دستمان برمیآید؟ درواقع، هیچی به جز متوقف کردن هوش مصنوعی، و به دلیل تمام فوایدی که گفتم و به دلیل اینکه من یک محقق هوش مصنوعی هستم من این مورد رو قبول ندارم. من میخوام که بتوانم همچنانروی هوش مصنوعی کار کنم.

پس باید این مساله رو بیشتر واکاوی کنیم. مشکل واقعا چی هست؟ چرا هوش مصنوعی بهترمنجر به فاجعه میشود؟

اینم یک نقل قول دیگه: «بهتره که مطمئن باشیمهدفی که در ماشین قرار میدهیم همان هدفی است که واقعا میخواهیم.» که توسط نوربرت وینر در ۱۹۶۰ گفته شده، بلافاصله بعد از اینکه وی دیدیکی از سیستمهای یادگیرنده اولیه بازی چکرز روبهتر از سازندگانش بازی میکند. ولی این جمله میتوانست توسط شاه میداس هم گفته شده باشد. شاه میداس گفت: «من میخواهمهرچه را که لمس میکنم تبدیل به طلا شود،» و او دقیقاً چیزی را که خواسته بود گرفت. و آن هدفی بود که وی در ماشین قرار داد. اینطور که میگن، و بعدش غذا، نوشیدنی و اقوامشتبدیل به طلا شدند. و از بدبختی و گشنگی مرد. پس ما به این مشکل میگوییم:«مشکل شاه میداس» که در آن هدف را چیزی قرار میدهیم، که واقعاً هم جهت باچیزی که ما ميخواهیم نیست. به بیان جدیدتر، به این مشکل میگیم:«مشکل هم جهت سازی ارزش»

هدف گذاری اشتباه تنها بخش مشکل نیست. بخش دیگری هم هست اگر شما یک هدف برای ماشین قرار دهید حتی به سادگیج «آوردن قهوه» ماشین به خودش میگه «چطوری ممکنه که مننتونم قهوه رو بیارم؟ یکی ممکنه منو خاموش کنه.. خب پس من باید کاری کنمکه جلوی این کار رو بگیرم. من دکمه «خاموش» خودمو غیرفعال میکنم. من هرکاری میکنم تااز خودم در برابر موانعی که سد راه هدفی که به من داده شده میشوند،دفاع کنم.» بنابراین، این دنبال کردن تک-ذهنه در یک حالت خیلی دفاعی از هدف، در واقع، هم جهت با اهداف گونه انسان نیست. این مشکلی هست که باهاش مواجه هستیم و در واقع، ایننکته با ارزش این سخنرانی هست. اگر میخواهید فقط یک چیز را به خاطرتون بسپرید، اون اینه که اگر شما بمیرین،دیگه نمیتونین قهوه رو بیارین

(خنده حاضرین)

خیلی سادست. فقط اینو یادتون باشه.روزی سه بار با خودتون تکرار کنین.

(خنده حضار)

و در واقع، این نکته دقیقا پلات فیلم 2001 [A space Odyssey] است. HAL یک هدف داره، یک ماموریت که همجهت با اهداف انسانها نیست و این باعث بروز مشکلاتی میشه البته خوشبختانه، HAL خیلی باهوش نیست اون نسبتا باهوش هست، ولی در نهایتDave گولش میزنه. و میتونه خاموشش کنه. ولی شاید ما خیلی خوش شانس نباشیم. پس باید چیکار کنیم؟

من سعی میکنم هوش مصنوعی رو باز تعریف کنم. تا از این تصور سنتی بیرون بیایم. که طبق اون، ماشینهایی هستند که به صورت هوشمند اهداف رو دنبال میکنن. ۳ تا اصل رو باید در نظر گرفت. اولین اصل، نوع دوستی هست.اگر شما دوست داشته باشین تنها هدف ربات این باشه که اهداف انسان رو واقعیت ببخشه. و ارزشهای انسانی رو. و منظورم از ارزشها،ارزشهای احساسی یا خیرخواهانه نیست. منظورم هر چیزی هست که انسان ترجیح میده زندگیش اون شکلی باشه. و این در واقع قانون آسیموف رو نقض میکنه. که ربات باید از حیات خودش محافظت کنه. ربات هیچ علاقهایبه مراقبت از حیات خودش نداره.

قانون دوم، قانون فروتنی هست.البته اگه خوشتون بیاد. و این قانون نقش مهمیدر امن کردن رباتها داره. طبق این قانون، ربات نمیدونه که ارزشهای انسانی چه چیزهایی هستند باید در راستای محقق شدنشون تلاش کنه،ولی نمیدونه چه چیزهایی هستند. و این از مشکل دنبال کردن تک-ذهنی هدف جلوگیری میکنه. این عدم قطعیت بسیار مهم هست.

حالا، برای اینکه ربات برای ما مفید باشه باید یک ایدهایازچیزی که میخوایم داشته باشه. و این اطلاعات رو در درجه اولاز مشاهده انتخابهای انسان به دست میآره. پس، انتخابهای خود ما هستندکه اطلاعات رو آشکار میکنن درباره چیزی که ما ترجیح میدیمزندگیمون شبیه به اون باشه. پس این ۳ اصل بیان شد. حالا بیاین ببینیم که این اصول،چگونه روی این سوال عمل میکند: «آیا میتونی ماشین رو خاموش کنی؟»همانطور که تورینگ پیشنهاد داد.

این یک ربات مدل PR2 هستش. که ما یک نمونه از آن در آزمایشگاهمون داریم و یک دکمه بزرگ قرمزبرای «خاموش» کردن در پشتش داره. سوال اینه که آیااین ربات بهتون اجازه میده که خاموشش کنین؟ اگر ما از راه سنتی عمل کنیم، بهش هدف این هدف رو میدیم:«قهوه روبیار، من باید قهوه رو بیارم من نمیتونم قهوه بیارم اگر مرده باشم» به وضوح، PR2 به سخنرانی من گوش کرده، پس میگهمن باید دکمه «خاموش» رو غیرفعال کنم. و احتمالاً با دستگاه شوک،به تمام مردم داخل استارباکس شلیک کنم! کسانی که ممکنه سد راه من باشن.

(خنده حاضرین)

پس این مسالهبه نظر اجتناب ناپذیر میاد، درسته؟ این حالت شکست به نظر اجتناب ناپذیر هست، و از داشتن یک هدف دقیق و محکم نشأت میگیره.

حالا چه اتفاقی میافتهاگه ماشین درباره هدف مطمئن نباشه؟ اینطوری، یک جور دیگه استدلال میکنه. میگه: «باشه، انسان ممکنه منو خاموش کنه ولی تنها در صورتی این کارو میکنهکه من کار اشتباهی بکنم. من نمیدونم چه کاری اشتباهه ولی میدونم که نمیخوام انجامش بدم.» این اصل اول و دوم گفته شده بود. «پس باید بذارم که که انسان منو خاموش کنه.» و درواقع، شما میتونین انگیزه ای که رباتبرای خاموش کردنش توسط انسان دارد رو محاسبه کنید، و این مستقیماً مرتبطه با درجه عدم قطعیت درباره اهداف اصولی دارد.

و وقتی که ماشین خاموش بشه اصل سوم وارد عمل میشه. ربات یه چیزی درباره اهداف یاد میگیره،باید پیگیر باشه، چون یاد میگیره کاری که کرده درست نبوده. در واقع، ما میتونیمبا استفاده درست از نمادهای یونانی همانطور که معمولاًریاضیدانان این کار رو میکنن میتونیم یک قضیه رو ثابت کنیم که میگه، این چنین رباتیقطعا برای انسان مفید است. قطعا وجود ماشینی که اینطوری طراحی شده باشه از نبودنش بهتره. این یک مثال ساده است،ولی قدم اول راه ماست. راه استفاده از هوش مصنوعی سازگار با انسان.

حالا، اصل سوم فکر کنم چیزی باشهکه احتمالا درکش براتون سخت باشه. احتمالا شما فکر میکنین که«راستش، من بد رفتار میکنم و نمیخوام که ربات من مثل من رفتار کنه. من نصف شب دزدکی میرم سر یخچال. یا فلان کار رو میکنم.» خیلی از کارها هست که شما دوست ندارینرباتتون انجامشون بده ولی در واقع، اصل مطلب اینطوری نیست. به صرف اینکه شما بد رفتار میکنین، دلیل نمیشه ربات هم از رفتار شما تقلید کنه. ربات قراره که انگیزههای شما رو بفهمه،و شاید در راستای رسیدن بهش کمکتون کنه، البته اگر مناسب باشه. ولی همچنان کاری سختیه. در واقع، کاری که ما سعی میکنیم انجام بدیم اینه که به ماشینها اجازه بدیمبرای هر فرد و هر زندگی ممکن پیشبینی کنند که آیا میتونن زنده بمونن و البته جان بقیه: این که کدوم رو ترجیح میدن؟ و سختیهای بسیار زیادیبرای انجام این کار وجود دارن؛ و من انتظار ندارمکه این مساله به زودی حل بشه. و چالش اصلی، در واقع خود ما هستیم.

همانطور که قبلا اشاره کردم،ما بد رفتار میکنیم. در واقعا بعضی از ماکاملا بدجنس هستیم. حالا همانطور که گفتم،ربات مجبور نیست که رفتار رو تقلید کنه. ربات از خودش هیچ هدفی ندارد. و کاملا نوع دوست هست. و برای این طراحی نشده که خواسته هاییک انسان یا کاربر رو برآورده کنه، در حقیقت، ربات بایدبه ترجیحات همه احترام بگذارد. پس میتونه مقدار مشخصیاز بدرفتاری رو تحمل کنه، و حتی میتونه سوءرفتار شما رو درک کنه، مثلا اینکه شمابه عنوان مامور اداره گذرنامه رشوه میگیرد دلیلش اینه که شما نان آور خانواده ایدو بچه هاتون رو به مدرسه بفرستین. ربات میتونه این موضوع رو بفهمه،و اینطوری نیست که دزدی کنه. در واقع کمکتون خواهد کردکه بچههاتون رو به مدرسه بفرستین.

ما همچنین از نظر محاسباتی هم محدود هستیم. Lee Sedol یک بازیکن با استعداد Go هست. ولی با این وجود بازنده است. پس اگر به حرکاتش دقت کنیم،یک حرکتی بود که به شکستش منجر شد. این به این معنی نیست که اون میخواست ببازه. پس برای فهمیدن رفتارش ما باید از یک مدلانسان شناختی استفاده کنیم که شامل محدودیتهای محاسباتی میشود.که یک مدل بسیار پیچیده است. ولی همچنان این چیزی هستکه برای فهمیدن میتونیم روش کار کنیم.

به نظر من به عنوان یک محقق هوش مصنوعی،دشوارترین بخش ماجرا این حقیقته که تعداد زیادی از ما(انسانها) وجود دارد. بنابراین ماشینها باید به طریقییک مصالحه و توازن بین ترجیحات افراد مختلف برقرار کنن. و راههای زیادی برای این کار وجود دارند. اقتصاددانها، جامعه شناس ها،فلاسفه اخلاق مدار متوجه شده اند که ما فعالانه در حال همکاری هستیم.

بیاین ببینیم وقتی کهاشتباه برداشت کنید چه اتفاقی خواهد افتاد. شما میتونین یک گفتگو داشته باشین، مثلا با دستیار شخصی هوشمندتان، که احتمالا در آینده نزدیک در دسترس باشد. مثلا به یک نمونه قوی از Siri فکر کنید Siri بهتون میگه که: «همسرتون زنگ زدتا برای شام امشب بهتون یادآوری کنه» و البته شما هم فراموش کرده بودیدچی؟ کدوم شام؟ راجع به چی حرف میزنی؟

امم...بیستمین سالگرد ازدواجتون ساعت ۷ شب

من نمیتونم برم.ساعت ۷:۳۰ با دبیرکل سازمان ملل جلسه دارم. چطوری اینطوری شد؟»

«من بهت هشدار داده بودم،ولی تو پیشنهاد من رو نشنیده گرفتی.»

«خب حالا چیکار کنم؟نمیتونم بهش بگم که من خیلی سرم شلوغه.

نگران نباش. من پروازش رو طوری گذاشتمکه تاخیر داشته باشه.»

(خنده حاضرین)

«یک نوع خطای کارکرد کامپیوتری.»

(خنده حاضرین)

«جدی؟ تو میتونی این کارو بکنی؟»

«ایشان ازتون عمیقاً عذرخواهی خواهد کرد. و از شما خواهد خواست کهفردا ناهار همدیگررو ببینین.»

(خنده حاضرین)

ولی اینجا یک مشکلی هست. ربات به وضوح دارهبه ارزشهای همسر من توجه میکنه: که همون "همسر شاد، زندگی شاد" است.

(خنده حاضرین)

میتونست جور دیگه ای باشه. ممکن بود شما بعد از یک روز سخت کاریبیاین خونه، و کامپیوتر بگه:«روز سخت و طولانی بود؟»

«آره، حتی برای ناهار خوردن هم وقت نداشتم.»

«باید خیلی گرسنت باشه.»

«آره دارم از گشنگی میمیرم.میتونی برام شام درست کنی؟»

«یه چیزی هست که باید بهت بگم.»

(خنده حاضرین)

«یه سری آدم در سودان جنوبی هستنکه بیشتر از تو در شرایط اضطراری قرار دارن»

(خنده حاضرین)

«پس من میرم. خودت شامت رو درست کن.»

(خنده حاضرین)

بنابراین باید این مشکلات رو حل کنیم و من با رغبت دارمروی این مشکلات کار میکنم.

دلایلی برای خوشبین بودن وجود دارن. یک دلیل، اینه که حجم زیادی از داده داریم. چون اگر یادتون باشه،من گفتم که رباتها هر چیزی که انسان تا کنون نوشتهرا خواهند خواند. بیشتر چیزهایی که ما مینویسیمدرباره کارهای بشر هستش. و بقیه مردم به خاطرش ناراحت میشن. پس انبوهی از داده برای یادگیری وجود داره.

یک انگیزه اقتصادی قوی هم برای انجام این کار هست. ربات خدمتکارتون در منزل رو تصور کنید. شما باز هم دیر از سر کار بر میگردین،و ربات باید به بچهها غذا بده. بچهها گشنه هستندو هیچ غذایی در یخچال نیست. و ربات گربه رو میبینه!

(خنده حاضرین)

و ربات تابع ارزش گذاری انسان ها روبه خوبی یاد نگرفته بنابراین نمیفهمه که ارزش معنوی گربهاز ارزش غذایی آن بیشتر است.

(خنده حضار)

بعدش چی میشه؟ یه چیزی تو این مایهها: "ربات ظالم، برای شام خانواده گربه میپزد" این حادثه احتمالاپایان صنعت رباتهای خانگی باشد. پس انگیزه زیادیبرای درست شدن این موضوع وجود دارد. خیلی زودتر از اینکهبه ماشینهای فوق هوشمند برسیم.

پس برای جمع بندی: من در اصل دارم سعی میکنمکه تعریف هوش مصنوعی رو طوری عوض کنم که ماشین های سودمندی داشته باشیم. و این اصول عبارتند از: ماشینها نوع دوست هستند. و فقط میخوان به اهدافی که ما داریم برسن. ولی درباره چیستی این اهداف مطمئن نیستند. و به ما نگاه میکنند تا یادبگیرنداین اهدافی که ما میخواهیم چه هستند. و امیدوارم در این فرآیند،ما هم یادبگیریم که مردم بهتری باشیم. خیلی ممنون.

(تشویق حاضرین)

کریس اندسون: خیلی جالب بود استوارت. ما یکم باید اینجا وایستیمچون عوامل دارن صحنه رو برای سخنرانی بعدی آماده میکنن.

چندتا سوال: ایده برنامهریزی در بی خبری به نظر خیلی قدرتمند میاد. وقتی که که به هوش قوی برسیم. چه چیزی مانع رباتی میشه که متنی رو میخونه و به این ایده میرسه که اون دانش بهتر از ندانستن است و اهدافش رو تغییر بدهو دوباره برنامه ریزی کنه؟

استوارت راسل: آره همانطور که گفتم،ما میخوایم که ربات درباره اهداف ما بیشتر یاد بگیره. ربات فقط وقتی مطمئن تر میشهکه موضوع درستتر باشه. شواهد گویا هستند. و ربات طوری طراحی میشه که درست تفسیر کنه. مثلا میفهمه که کتابها خیلیدر شواهدی که دارند جانبدارانه عمل میکنند. فقط درباره پادشاهان و شاهزادگان حرف میزنن. و مردان سفید پوست فوق العاده ایکه مشغول کاری هستند. بنابراین این یک مشکل پیچیده است. ولی همانطور که رباتداره درباره اهداف ما یاد میگیره. برای ما بیشتر و بیشتر کاربردی میشه.

ک آ: پس نمیشه اینو تبدیل به یک قانون کنیم و به صورت کورکورانه بگیم که: «اگر هر انسانی سعی کرد منو خاموش کنه من پیروی میکنم. من پیروی میکنم.»

قطعا اینطور نیست. اینطوری خیلی بد میشد. مثلا تصور کنید که یک ماشین خودران دارید. و میخواهید بچه پنج سالتون رو به مدرسه بفرستید. آیا شما میخواین که بچه پنج سالتونبتونه ماشین رو موقع رانندگی خاموش کنه؟ احتمالا نه. پس ربات باید بتونه درک کنهکه آدم چقدر منطقی و معقول هست. هرچه انسان منطقی تر باشد، ربات بیشتر تمایل داردکه بگذارد خاموش شود. اگر شخص کاملا تصادفی یا خرابکار باشد ربات کمتر تمایل دارد که بگذارد خاموش شود.

خب استوارت، فقط میتونم بگم که من واقعا، واقعا امیدوارم تو برای مااین مشکل رو حل کنی. ممنون بابت سخنرانی.فوق العاده بود.

ممنون.

(تشویق حضار)