ماشینهای خودران چه تصمیمهای اخلاقی باید بگیرند؟

متن سخنرانی :

امروز قراره دربارهتکنولوژی و جامعه صحبت کنم. دپارتمان حمل و نقل،در سال گذشته تخمین زد که فقط در آمریکا، ۳۵،۰۰۰ نفربه علت تصادفات ترافیکی مردهاند. در سراسر جهان هر ساله ۱.۲ میلیون نفربه خاطر سوانح ترافیکی میمیرند. اگه راهی بود که میتونسیتم باهاش۹۰ درصد این تصادفها رو حذف کنیم، آیا ازش حمایت میکردین؟ البته که میکردین. این چیزیه که تکنولوژی ماشین خودران( بدونِ راننده) وعده میده که بهش به به وسیله منبع اصلی تصادفات میرسه-- خطای انسان.حالا خودتون رو تصور کنیدکه در سال ۲۰۳۰ در یک ماشین خودران نشستید، و دارین این ویدیو قدیمی TEDxCambrdige رو میبینین.

(خنده حاضرین)

ناگهان، ماشین به مشکل مکانیکی میخورهو نمیتونه متوقف شه. اگه ماشین ادامه بده، به عدهای از عابرین پیادهکه در حال عبور از خیابان هستند خواهد زد. ولی ممکنه ماشین منحرف بشه، و به یکی از افراد داخل پیاده رو بزنه، و اونا رو برای نجات جان عابران پیاده بکشه. ماشین باید چیکار کنهو چه کسی باید تصمیم بگیره؟ اگه به جای اینکارماشین بتونه به سمت دیوار منحرف شه، و تصادف کنه و شما که سرنشین هستین رو بکشه، برای نجات اون عابران پیاده، اونوقت چی؟ این سناریواز مشکل قطار برقی الهام گرفته است، که چندین دهه پیشتوسط فلاسفه اختراع شد تا درباره اخلاق فکر کنند.

حالا، جوری که مابه این مساله فکر میکنیم مهمه. مثلا ممکنه اصلاً بهش فکر نکنیم. ممکنه بگید این سناریو غیر واقعیه، یا غیر محتمل، یا احمقانه. ولی من فکر میکنم این انتقاداز نکته اصلی غافل میشه چون سناریو رو خیلی سطحی بررسی میکنه. البته که هیچ تصادفی این شکلی نیست، هیچ تصادفی دو یا سه گزینه نداره که توش هرکی به طریقی میمیره. به جاش، ماشین میره سراغ حساب کردن چیزی مثل احتمال اصابت به گروهی از مردم، وقتی به جهتی منحرف بشیننسبت به یک جهت دیگه، شاید اندکی ریسک رو برایسرنشینان یا سایر رانندگان نسبت به عابران پیاده زیاد کنین. این محاسبات پیچیدهتر هم خواهد شد، ولی همچنان شامل بده بستانهایی خواهد بود، و بده بستانهاغالباً نیازمند اخلاقیات هستند.

ممکنه بگیم،"خب، بیا نگران این مساله نباشیم. بیاین صبر کنیم تا تکنولوژیکاملاً آماده و صد درصد امن بشه." فرض کنید ما بتونیمواقعاً ۹۰ درصد این تصادفات رو حذف کنیم، یا حتی ۹۹ درصدشون رو طی ۱۰ سال آینده. اگه حذف کردن اون ۱ درصدِباقی مونده از تصادفات به ۵۰ سال تحقیق نیاز داشته باشه،اونوقت تکلیف چیه؟ آیا باید قید این تکنولوژی رو بزنیم؟ که یعنی ۶۰ میلیون مرگ در تصادفات رانندگی اگر که با همین نرخ تصادفات پیش بریم. منظورم اینه که، صبر کردن برای رسیدن به ایمنی کاملیک گزینه هست، ولی بده-بستانهای خودش رو داره.

مردم در رسانههای اجتماعی به انواع مختلفی از روشها رسیدن که به این مشکل فکر نکنیم. یه نفر پیشنهاد داده بود کهماشین باید به سمتی منحرف بشه که ماشین بخوره به جایی بین سرنشینها --

(خنده حاضرین)

و عابر پیاده. البته اگه این کاریه که ماشین میتونه بکنه،باید همین کار رو بکنه. ولی ما درباره سناریوهایی کنجکاویمکه نمیشه این کار رو کرد. و راه مورد علاقه خودمپیشنهاد یک بلاگنویس هستش که داخل ماشین یک دکمه پرتاب به بیرون باشهکه فشارش بدین --

(خنده حاضرین)

درست قبل از خود نابودسازی ماشین.

(خنده حاضرین)

پس اگه ما قبول کنیم که ماشینهابده-بستانهایی رو در جاده خواهند داشت، تکلیف این بده بستانها چیه، و چطور تصمیم میگیریم؟ خب، شاید باید یه نظرسنجی برگزار کنیمتا ببینیم جامعه چی میخواد، چون در نهایت، قوانین و مقرراتبازتابی از ارزشهای اجتماعی هستند.

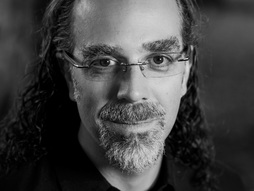

ما هم همین کارو کردیم. با همکارانم، عظیم شریف و ژان-فرانیوا بونفون یک نظرسنجی برگزار کردیم که توش به مردماین سناریوها رو نشون میدادیم. بهشون دوتا حق انتخاب میدادیم کهالهام گرفته از دو فیلسوف بودن: امانوئل کانت و جرمی بنتهام. بنتهام میگه که ماشینباید از اخلاق سودگرایانه پیروی کنه: باید کاری کنه که مجموعِ ضرر کمینه بشه -- حتی اگه این کارباعث کشته شدن یک عابر پیاده بشه حتی اگه این کار یک سرنشین رو بکشه. امانوئل کانت میگه ماشین بایداز اصول تکلیفی پیروی کنه، مثل فرمان "نباید به قتل برسانی." پس شما نباید کاری کنین که به صراحتبه یک انسان آسیب بزنین، و باید بذارین که ماشین به مسیرش ادامه بده حتی اگه به مردم بیشتری آسیب بزنه.

شما نظرتون چیه؟ بنتهام درست میگه یا کانت؟ ما به این نتیجه رسیدیم. بیشتر مردم میگن بنتهام. به نظر میرسه مردم میخوان که ماشینسودمندگرا باشه، مجموع ضرر رو کمینه کنه، و این کاریه که همه باید بکنیم. مشکل حل شد. ولی یک گیر کوچیک اینجا هست. وقتی ما از مردم پرسیدیم کهآیا شما اینجور ماشینها رو میخرین، گفتن: "قطعا نه."

(خنده حاضرین)

مردم میخوان ماشینها رو بخرن کهتحت هر شرایطی ازشون محافظت کنه، ولی میخوان بقیه ماشینی رو بخرن کهضرر رو کمینه کنه.

(خنده حاضرین)

ما این مشکل رو قبلاً هم دیدهایم. بهش میگن دوراهی اجتماعی. و برای اینکه دوراهی اجتماعی رو درک کنین، باید در تاریخ یه ذره به عقب برگردیم. حدود سال ۱۸۰۰ میلادی، اقتصاددان انگلیسی ویلیام فورستر للویدرسالهای رو منتشر کرد که این سناریوها رو توش توضیح میداد. فرض کنید گروهی از چوپانها دارین -- چوپانهای انگلیسی -- که زمین مشترکیبرای چروندن گوسفنداشون دارن. حالا، اگه هر چوپانتعداد مشخصی گوسفند بیاره -- مثلاً هرکی ۳ تا گوسفند -- زمین سالم میمونه و کاریش نمیشه، چوپانها خوشحالن، گوسفندها خوشحالن، همه چی خوبه. حالا اگه یکی از چوپانهایه گوسفند اضافی بیاره، اون چوپان یکم وضعش بهتر میشه،و هیچکس ضرر نمیکنه. ولی اگه همه چوپانها این تصمیم فردی روکه برای هرکدومشون منطقیه بگیرن، زمین بیش از اندازه بهش فشار میاد،و خراب میشه. چوپانها ضرر میکنن، و البته گوسفندها هم ضرر میکنن.

این مشکل رو خیلی جاها میبینیم: مشکل حل ماهیگیری بیش از اندازه، یا کاهش انتشار کربن،برای کند کردن روند تغییرات اقلیمی. وقتی این مشکل به مقرراتماشینهای بدون راننده(خودران) میرسه، زمین مشترک برای چَراهمون امنیت عمومی میشه -- که ارزش مشترک هست -- و چوپانها همون سرنشینها میشن یا صاحبان ماشینها که دارن رانندگی میکنن. و تصمیم فردی عاقلانه که اولیت دادن به امنیت خود شخص هست، ممکنه به صورت جمعی در حالتخریب مال مشترکشون(زمین چَرا) باشن، که کمینه کردن کل ضرر هست. بهش میگن تراژدی اشتراکها، به طور سنتی، ولی من فکر میکنم در موردماشینهای بدون راننده(خودران)، شاید مشکل یه ذره ظریفتر باشه چون حتماً اونی که تصمیم رو میگیره، یک انسان نیست. ممکنه سازندگان ماشینخودروها رو طوری برنامهریزی کنن، که امنیت مشتریانشون رو بیشینه کنه، و اون ماشینها شاید خودشون یاد بگیرن کهبه صورت اتوماتیک انجام این کار خطراتی روبرای عابرین پیاده داره. مثلاً توی مثال گوسفندها، یک گوسفند الکتریکی داشته باشیمکه ذهن خودش رو داره.

(خنده حاضرین)

و گوسفندها شاید برن و بِچرنددر حالی که چوپان نمیدونه.

این چیزیه که اسمش رو میذاریمتراژدی اشتراکات الگورتیمی، که چالشهای جدیدی رو در خودش داره. معمولاً و به طور سنتی، ما این نوع دوراهیهای اجتماعی روبا استفاده از مقررات حل میکنیم، پس حکومتها یا جوامع گِرد هم میان، و تصمیم میگیرن که چه نتیجهای رو میخوان، و چه محدودیتهایی رویرفتارهای فردی باید اعمال کنند. و بعدش با استفاده از نظارت و الزام، میتونن مطمئن شن که منافع عمومی حفظ میشه. پس چرا نیایم، به عنوان قانون گذاران، بخوایم که همه ماشینها ضرر رو کمینه کنن؟ به هرحال، این چیزیه که همهادعا میکنن میخوانش. و مهمتر از اون، مطمئناً منِ نوعی، اگه یه ماشین بخرم که ممکن باشهمن رو در یه حالت خیلی خاص قربانی کنه، من تنها احمقی نیستم که این کار رو میکنه در حالی که بقیه ازمحافظت بیقید و شرط لذت میبرن.

در نظرسنجی ما، از مردم پرسیدیم که آیااز قانون گذاری حمایت میکنن یا نه و به این نتایج رسیدیم. اول از همه، مردم به قانون گذاری نه گفتند. و دوم، اونا گفتن "خب اگه شما برای ماشینها قانون بذارینکه این کار رو بکنن و ضرر رو کمینه کنن، من اون ماشینها رو نمیخرم." پس به طرز مسخرهای، با قانونگذاری برای ماشینهابرای کمینه کردن ضرر، ما بیشتر ضرر میکنیم! چون مردم نمیخوان کهاز تکنولوژی امنتر استفاده کنن حتی اگه خیلی خیلی امنتر ازرانندگان انسانی باشه.

من جواب نهایی این معما رو نمیدونم، ولی فکر میکنم به عنوان یک نقطه شروع، ما لازم داریم که همه جمع شیم، تا تصمیم بگیریم که چه بده-بستونهاییرو باهاش کنار میایم و به راههایی برسیم کهبتونیم اون بده-بستونها رو اجرایی کنیم.

به عنوان یک نقطه شروع،دانشجویان فوقالعاده من، ادموند اواد و سوهن دئسوزا. سایت ماشین با اخلاق رو ساختند، -- که سناریوهای تصادفیبرای شما تولید میکنه اساساً دنبالهای از تعدادی مساله تصادفی که شما باید تصمیم بگیرین که ماشیندر سناریو گفته شده چه کار باید بکنه. و ما حتی سن و نوع قربانیها رو عوض میکنیم. تا اینجا ما بیش از ۵ میلیون تصمیماز این سایت برای این سناریوها جمع کردیم توسط یک میلیون نفر در سرتاسر جهان و این کمک میکنه کهیک تصویر ابتدایی داشته باشیم از اینکه مردمبا چه بده-بستانهایی کنار میان و چه چیزهایی براشون مهمه -- حتی در فرهنگهای مختلف. ولی مهمتر از این، انجام این کار،به مردم کمک میکنه که دشوار این تصمیم گرفتنها رو بشناسن و اینکه قانونگذارانبا تصمیمهای غیرممکن روبرو هستند. و شاید این به ما به عنوان یک جامعه کمک کنهانواع بده-بستانها رو درک کنیم که بالاخره در مقررات به کار خواهد رفت.

و در واقع، من خیلی خوشحالم که میشنوم اولین مجموعه قوانین و مقرارت توسط وزارت حمل و نقل -- هفته پیش اعلام شد -- شامل یک چک لیست ۱۵ امتیازیبرای تمام خودروسازان، و شماره ۱۴ یک ملاحظه اخلاقی بود -- با آن چطوری کنار خواهید آمد. همچنین ما افرادی رو داریم کهبا دادن خلاصهای از آنچه انتخاب کردهاند تصمیماتشون رو بازتاب میدن. بهتون یک مثال نشون میدم -- فقط بهتون هشدار میدم کهاین یک مثال عادی نیست، یا کاربر عادی. این مثال بیشترین قربانی و بیشترین نجات توسط این آدم رو نشون میده.

(خنده حاضرین)

بعضی از شما شایدبا نظر این مرد موافق باشین، یا شایدم نظر این زن، نمیدونم. ولی به نظر میرسه این فردیکم سرنشینها رو نسبت به عابرین پیاده توی انتخابهاش ترجیح میده و از تنبیه کردن عابرین داخلخیابون خوشحال میشه.

(خنده حاضرین)

حالا بیاین جمع بندی کنیم. ما با یک سوال که اسمش رودوراهی اخلاقی میذاریم، شروع کردیم -- که ماشین توی سناریو خاص چه کار باید بکنه: منحرف بشه یا ادامه بده؟ ولی بعدش فهمیدیم که این مساله دیگهای بود. مساله، همنظر کردن جامعهو اجرای بده-بستانهایی بود که جامعه باهاش کنار میاد. که یک معمای اجتماعی هست.

در سال ۱۹۴۰، ایزاک آسیموفقوانین مشهورش برای رباتها را نوشت -- سه قانون برای رباتها. ربات نباید به انسان آسیب بزنه، ربات نباید از انسان سرپیچی کنه، و ربات نباید به خودش اجازه بده که آسیب بزنه -- به ترتیب اهمیت از اول به سوم. ولی بعد از گذشت حدود ۴۰ سال و بعد داستانهای زیادی کهبه این قوانین فشار آوردن، آسیموف قانون صفرم رو مطرح کرد که بر هر سه قانون قبلی تقدم داره، و اون این بود که ربات نباید بهکلیت انسانها آسیب بزنه. من نمیدونم مصداق این قانون در زمینهماشینهای خودران چی میشه یا هر حالت خاصی، و نمیدونم که ما چطوری میخوایم اجراش کنیم، ولی فکر میکنم که با فهمیدنِ اینکه مقررات ماشینهای خودران تنها یک مساله مرتبط با تکنولوژی نیست و یک مساله همکاری اجتماعی هم هست، میتونم امیدوار باشم که حداقل شروع بهپرسیدن سوالات درست کنیم.

سپاس گزارم.

(تشویق حاضرین)